Klimafakten

Kann man sich auf die Klimaforschung verlassen?

Behauptung: „Klimamodelle sind nicht verlässlich"

„Klimamodelle sind unzuverlässig, für verlässliche Prognosen oder gar weitreichende politische Entscheidungen sind sie jedenfalls unbrauchbar.“

Antwort: Bei der Modellierung des Klimasystems hat die Forschung in den vergangenen Jahrzehnten große Fortschritte gemacht. Trotz einiger Unschärfen gelingt es dank komplexer Modelle und leistungsfähiger Computer längst, bisherige Klimaentwicklungen verlässlich zu rekonstruieren und künftige Entwicklungen zu projizieren. Die Qualität der Modelle zeigt sich zum Beispiel, wenn man einstige Vorhersagen mit der später beobachteten Realität vergleicht.

Klimamodelle sind extrem komplexe Computerprogramme. Mit ihnen wird versucht, Entwicklungen von und Wechselwirkungen zwischen den einzelnen Komponenten des Klimasystems der Erde zu simulieren – also beispielsweise von Atmosphäre und Ozeanen, von Wolken, Schnee und Eismassen oder von verschiedenen geologischen, biologischen und chemischen Prozessen.

Die ersten, noch relativ simplen Klimamodelle wurden in den 1960er Jahren entwickelt (vgl. z.B. Manabe/Bryan 1969); der US-japanische Forscher Syukuro Manabe wurde übrigens gemeinsam mit dem Deutschen Klaus Hasselmann und dem Italiener Girogio Parisi für Pionierleistungen auf diesem Gebiet 2021 mit dem Physik-Nobelpreis geehrt. Schon diese groben Modelle kamen auf – mit heutigem Wissen betrachtet – relativ zutreffende Ergebnisse: So erwarteten Manabe/Wetherald 1967 einen Temperaturanstieg um etwa 2 °C bei Verdoppelung des Kohlendioxid-Gehalts der Erdatmosphäre. Tatsächlich hat der Mensch die CO2-Konzentration gegenüber vorindustriellem Niveau mittlerweile um rund 50 Prozent erhöht – und die Erde hat sich um knapp ein Grad Celsius erwärmt. (Aktuelle Schätzungen der sogenannten "Klimasensitivität" liegen zwischen 2,5 °C und 4,5 °C.)

Im Laufe der Jahrzehnte entstanden dann immer ausgefeiltere Modelle. Häufig genutzt werden heute einerseits „Erdsystemmodelle mittlerer Komplexität“ (engl. Abkürzung: EMIC), die bewusst vereinfacht sind und mit denen sich längere Zeitabschnitte (Jahrhunderte oder Jahrtausende) simulieren lassen. Daneben werden für die Projektion der Klimaentwicklung der kommenden Jahrzehnte sogenannte „Globale Zirkulationsmodelle“ (engl. Abkürzung: GCM) eingesetzt, die einzelne Teile des Klimasystem sowie deren Zusammenwirken so genau wie möglich nachvollziehen. Durch immer bessere Eingangsdaten und immer leistungsfähigere Großrechner sind hier in den vergangenen Jahren auch immer kleinteiligere Modellierungen für einzelne Regionen der Erde möglich geworden. Doch trotz aller Fortschritte und aller Komplexität bleiben Klimamodelle natürlich vereinfachte Abbildungen der Wirklichkeit.

Für die Berechnung der Klimamodelle wird die Erde mit einem dreidimensionalen Gitter überzogen, für jede Gitterzelle sowie den Austausch mit benachbarten Zellen werden dann die einzelnen Parameter berechnet. Dank immer schnellerer Hochleistungscomputer konnten in die Klimamodelle immer mehr physikalische Prozesse integriert werden. Besonders die Vorgänge in den Ozeanen können inzwischen wesentlich detaillierter und naturnäher als früher in den Modellen dargestellt werden.

Um die Unsicherheiten bei den Ergebnissen zu verringern, verwendet die Forschung meist verschiedene Modelle bzw. lassen dasselbe Modell Rechendurchläufe in sehr großer Zahl absolvieren. Bei den Ergebnissen von Klimamodellen werden daher üblicherweise die Mittelwerte vieler Berechnungen veröffentlicht und auch die Spannbreite der erhaltenen Ergebnisse. Um die Grenzen der Klimamodellierung zu betonen, wird in der Forschung auch nicht von Klima"prognosen" gesprochen, sondern von Klima"projektionen" , da jeder Simulation für die Zukunft bestimmte Annahmen zugrunde liegen, etwa über die Emissionen von Treibhausgasen. Diese sind kaum vorhersagbar und natürlich durch Menschen und ihr Verhalten beeinflussbar.

Wie "gut" sind die heutigen Klimamodelle?

Der Fünfte Sachstandsbericht des IPCC von 2013/14 (AR5) hat diese Frage ausführlich auf mehr als einhundert Seiten behandelt (Band 1, Kapitel 9). Das klare Fazit lautete schon damals (deutsche Übersetzung des SPM, S. 13):

„Die Modelle geben die beobachteten Muster und Trends [des Klimas] über viele Dekaden der Erdoberflächentemperatur im kontinentalen Maßstab wieder, einschließlich der stärkeren Erwärmung seit Mitte des 20. Jahrhunderts und der unmittelbar auf große Vulkaneruptionen folgenden Abkühlung.“

Im Sechsten Sachstandsbericht beschäftigt sich der Weltklimarat nicht ganz so ausführlich mit diesen Fragen. Aber er konstatiert, dass die neuste Modellgeneration (CMIP6) "neue und bessere Repräsentationen von physikalischen, chemischen und biologischen Prozessen enthalten" und Ergebnisse "in höherer Auflösung" liefern können als die Modelle, die in früheren Sachstandsberichten betrachtet wurden – deshalb "hat sich die Simulation der meisten großskaligen Indikatoren des Klimawandels und vieler anderer Aspekte des Klimasystems verbessert" (IPCC 2021, AR6, WG1, TS 1.2.2 – siehe auch FAQ3.1 "Werden Klimamodelle besser?").

Hinter der Frage nach der Güte der Klimamodelle stecken eigentlich zwei:

- Können Klimamodelle die Vergangenheit verlässlich rekonstruieren?

- Und können sie verlässliche Vorausschauen liefern?

Rekonstruieren Klimamodelle das vergangene Klima verlässlich?

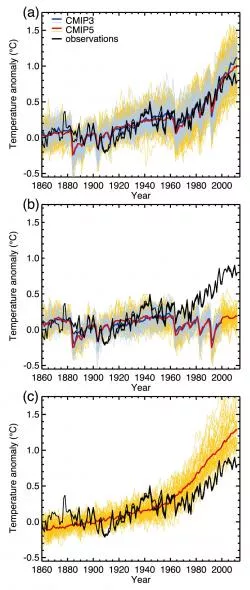

Diese erste Frage ist relativ leicht zu beantworten, denn für die Vergangenheit kann man die Ergebnisse von Modellierungen mit den tatsächlich gemessenen Temperaturen vergleichen. Abbildung 1 (aus dem Fünften IPCC-Sachstandsbericht) zeigt Modellberechnungen für die Erdmitteltemperatur seit Mitte des 19. Jahrhunderts – und zwar sowohl mit als auch ohne Einwirkung des Menschen. Es ist deutlich zu sehen (im obersten Teil der Grafik), dass Klimamodelle die real gemessenen Temperaturen (schwarze Zickzack-Kurve) als Zusammenspiel natürlicher und anthropogener Einflüsse gut nachbilden können.

Abbildung 1: Vergleich zwischen der real beobachteten Entwicklung der Erdmitteltemperatur (jeweils schwarze Kurve, kombiniert aus drei separaten Datensätzen) sowie von Klimamodellrechnungen. Die feinen orangen und bläulichen Linien zeigen die Ergebnisse einzelner Modellberechnungen, die fette rote bzw. blaue Kurve den jeweiligen Mittelwert. Oben (a) sind in den Modellen natürliche und menschliche Einflüsse auf das Klima berücksichtigt, in der Mitte (b) nur natürliche Einflüsse (beispielsweise von Schwankungen der Sonnenaktivität und Vulkanausbrüchen), unten (c) sind Simulationen der Temperaturentwicklung seit dem 19. Jahrhundert dargestellt, die ausschließlich die menschengemachten Emissionen von Treibhausgasen berücksichtigen. Eindeutig am besten stimmen reale Messwerte und Modellergebnisse in Grafik (a) überein; und Grafik (c) zeigt an, dass die Erderwärmung in den vergangenen Jahrzehnten ohne den Effekt natürlicher Klimaeinflüsse höher ausgefallen wäre (rote Linien) als sie real war (schwarze Linie), dass also natürliche Einflüsse die menschengemachte Erwärmung etwas gedämpft haben. Quelle: IPCC 2013, AR5, WG1, Kap.10, Abb.10.01(Ausschnitt)

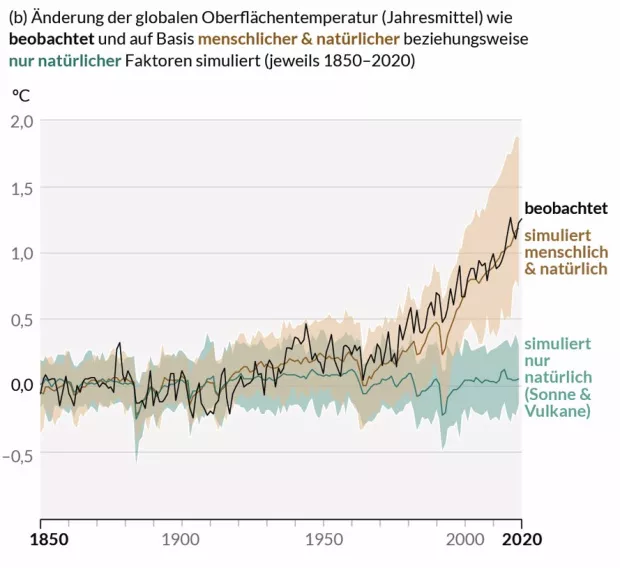

Eine ähnliche Grafik findet sich im Sechsten IPCC-Sachstandsbericht (AR6), in ihr sind die Temperaturkurven bis 2020 fortgeschrieben:

Abbildung 2: Vergleich von Realität und Modellergebnissen - die schwarze Kurve zeigt real beobachtete Temperaturen (bzw. ihre Abweichung vom langjährigen Mittel) zwischen 1850 und 2020, türkis dargestellt sind die Ergebnisse von Modellen, die nur natürliche Klimafaktoren berücksichtigen, braun eingezeichnet sind Ergebnisse von Modellen, die neben den natürlichen Faktoren auch den menschlichen Einfluss (Emissionen an Treibhausgasen oder Abholzung von Wäldern) berücksichtigen; Quelle: IPCC 2021, AR6, WG 1, SPM, Figure 1b

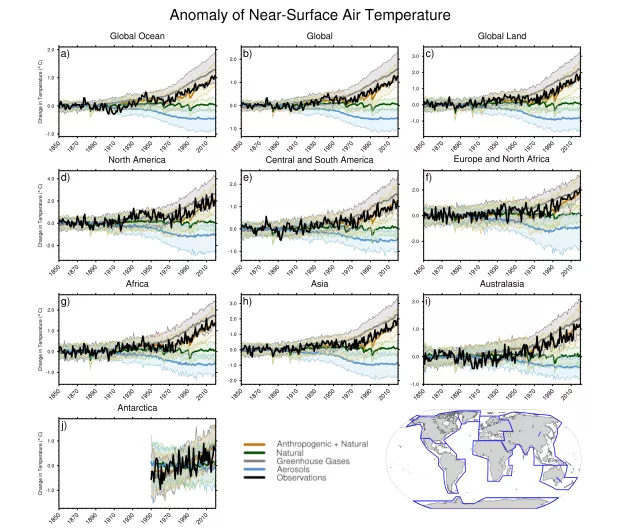

Der AR6 enthält außerdem eine Grafik, in der die Übereinstimmung zwischen Computermodellen und realen Beobachtungen separat für die einzelnen Kontinente dargestellt ist:

Abbildung 3: Vergleich der beobachteten und simulierten Erhitzung der Welt (obere Reihe Mitte), der Weltmeere (oben rechts) und der globalen Landmassen (oben rechts) sowie für sieben Einzelkontinente; die dicke, schwarze Kurve zeigt die real gemessenen Temperaturen bzw. deren Veränderung – sie verlaufen sehr nah an den Ergebnissen von Klimamodell-Berechnungen, die natürliche und menschliche Einflüsse berücksichtigen (bräunlich eingezeichnet); Quelle: IPCC 2021, WG1, Kap. 3, Figure 3.9

Dasselbe gilt für längere Zeiträume und die oben genannten EMIC-Klimamodelle, wie beispielsweise eine Studie zeigte, die Temperaturdaten und Modellergebnisse bis zurück zum Jahr 850 verglich (Eby et al. 2013). Auch neuere Studien, die Beobachtungsdaten zur Erwärmung der Ozeane mit Ergebnissen von Modellrechnungen verglichen, bestätigten die große Übereinstimmung (Cheng et al. 2016, Gleckler et al. 2016). An der grundsätzlichen Verlässlichkeit der heutigen Klimamodelle ändert auch die vorübergehende Verlangsamung der Erwärmung zwischen 1998 und 2014 (manchmal fälschlich „Erwärmungspause“ genannt) nichts – denn einzelne Modelldurchläufe ergaben und ergeben auch zwischenzeitliche Phasen mit schneller oder langsamer Erwärmung.

Können Computermodelle das künftige Klima vorhersagen?

Gelegentlich ist von Kritikern der Klimaforschung zu hören, die Wissenschaft könne ja nicht einmal das Wetter für die nächsten Wochen vorhersagen – wie solle das dann für das Klima in ein paar Jahrzehnten funktionieren? Dieser (rhetorischen) Frage liegt die fehlende Unterscheidung zwischen Wetter und Klimazugrunde: Ersteres ist tatsächlich unberechenbar und schwer über längere Zeiträume vorhersagbar, letzteres hingegen ein Langzeitdurchschnitt des Wetters. Zwar kann man tatsächlich das Wetter kaum mehr als zwei Wochen im Voraus vorhersagen – aber man kann beispielsweise im Winter mit sehr hoher Sicherheit vorhersagen, dass es sechs Monate später wärmer sein wird.

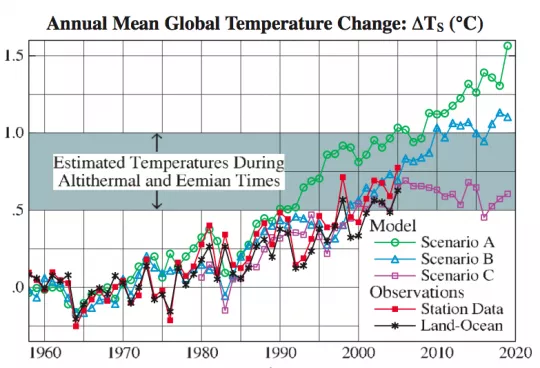

Aber selbstverständlich bergen Klimaprojektionen eine Reihe von Schwierigkeiten. So ist etwa die künftige Aktivität der Sonne nicht sicher absehbar, auch lassen sich kurzfristige Einflüsse wie der Auswurf von Ascheteilchen und anderen Aerosolen bei Vulkanausbrüchen schwerlich vorhersagen. Doch sind die Wirkungsweisen der wichtigsten Faktoren, die das Klima beeinflussen, lange bekannt. Ende der 1980er Jahre veröffentlichte der US-Klimatologe James Hansen Schätzungen zur künftigen Temperaturentwicklung der Erde (Hansen et al. 1988). Schon diese frühen Berechnungen zeigen – siehe Abbildung 4 – eine ziemlich gute Übereinstimmung mit nachfolgenden Beobachtungen (Hansen et al. 2006). Und seitdem sind, wie gesagt, die Klimamodelle deutlich verbessert worden.

Abbildung 4: Vergleich von Simulationen der globalen Temperaturänderung und späterer tatsächlicher Beobachtung – grün, blau und violett verzeichnet ist die weltweite Oberflächentemperatur für verschiedene Szenarien von menschlichen Treibhausgasemissionen, rot und schwarz dargestellt sind zwei verschiedene Analysen tatsächlicher Beobachtungsdaten; Quelle: Hansen 2006

Die engste Korrelation mit den später real gemessenen Temperaturen zeigte Hansens Szenario B. Dieses hatte er einst selbst für die wahrscheinlichste Variante gehalten, und es stimmte dann tatsächlich am stärksten mit den realen CO2-Emissionen überein. Zwar gibt es bei den Temperaturkurven von Jahr zu Jahr Abweichungen – diese sind jedoch zu erwarten. Die unberechenbare Natur des Wetters mag die Bestimmung des menschlichen Einflusses erschweren, doch die Tendenz insgesamt ist kalkulierbar.

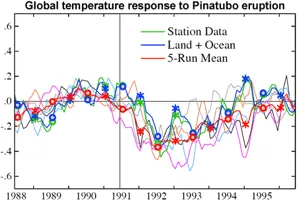

Mit dem Ausbruch des philippinischen Vulkans Pinatubo im Jahr 1991 bot sich die Chance herauszufinden, wie zutreffend die Vorhersagen von Modellen über die Auswirkungen von Sulfat-Aerosolen auf das Klima sind. Ergebnis: Die Modelle sagten ziemlich akkurat die vorübergehende weltweite Abkühlung von ca. 0,5 °C voraus, die bald auf den Ausbruch folgte (siehe Abbildung 5). Mehr noch: Auch die Rückkopplungseffekte etwa von Sonneneinstrahlung und Wasserdampf, die in die Modelle eingeflossen waren, wurden quantitativ bestätigt (Hansen et al. 2007).

Abbildung 5: Tatsächlich beobachtete und simulierte globale Temperaturschwankung nach dem Pinatubo-Ausbruch - grün markiert ist die von Wetterstationen beobachtete Temperatur, in Blau Land- und Meerestemperaturen. Rot verzeichnet ist das durchschnittliche Ergebnis der Modellierungen – das Absinken der globalen Temperatur um rund 0,5 Grad Celsius ein Jahr nach der Eruption ist ziemlich genau getroffen, ebenso der folgende schrittweise Wiederanstieg (das Zickzack der kurzfristigen Schwankungen ist dabei normal); Quelle: Supplementary Material in Hansen 2007

Im Laufe der Jahre konnten Forscher den Einfluss natürlicher Faktoren auf das Klimasystem (wie vulkanische Aktivitäten oder das Ozeanphänomen El Niño) zunehmend genau identifizieren, isolieren und mit Klimamodellen reproduzieren (Fyfe et al. 2010; IPCC 2021, AR6, WG1, Kapitel 7.3).

Wie "gut" Klimamodelle inzwischen sind, wird seit Jahren und sehr anschaulich auf dem Internet-Blog RealClimate gezeigt, der von aktiven Klimaforschern betrieben wird: In die Ergebnisgrafiken von Modellrechnungen aus der Vergangenheit werden dort fortlaufend die später in der Realität gemessenen Temperaturen eingezeichnet – das Ergebnis können Sie hier anschauen: Die Kurven der realen Erwärmung bewegen sich ziemlich genau in dem Schwankungsbereich, den die Modelle vorausberechnet hatten.

Einer der regelmäßigen Autoren des Blogs, der US-Klimaforscher Gavin Schmidt, war auch an einer Studie beteiligt, die systematisch und im Detail die Genauigkeit von Modellprojektionen aus den Jahren 1970 bis 2007 überprüft hat (Hausfather et al. 2020). Ihr Fazit war ebenfalls deutlich:

„Wir kommen zu dem Ergebnis, dass Klimamodelle aus den vergangenen fünf Jahrzehnten gekonnt spätere Veränderungen der Erdmitteltemperatur vorhergesagt haben."

Unwägbarkeiten bei Klimaprognosen

Ein bisweilen geäußerter Vorwurf lautet, Klimamodelle würden die Auswirkungen der CO2-Anreicherung in der Atmosphäre übertreiben. Grundsätzlich können sich Unsicherheiten natürlich in zu hohen oder auch zu niedrigen Ergebnissen. Und es stimmt, dass Modelle des Klimasystems der Erde für lange Zeit größere Unsicherheiten nach oben und unten – doch mittlerweile konnten sich die Schätzungen zu den Auswirkungen vor allem nach unten hin deutlich verbessern. Verantwortlich für die Ungewissheiten sind aber generell nicht irgendwelche Absichten der Klimaforscherende, die diese Modelle entwickeln – sondern es ist, wie zwei von ihnen in einem Aufsatz erklärten, eine „unvermeidliche Konsequenz“ der Grundcharakteristika des Klimasystems (Roe/Baker 2007): Weil das genaue Ausmaß des Temperaturanstiegs bei fixer Zunahme von Treibhausgasen sehr stark von verschiedenen Rückkopplungsprozessen abhängt und deren Gesamtwirkung insgesamt eine verstärkende ist, ergeben sich bei der oberen Grenze der zu erwartenden Temperaturen eben größere Unsicherheiten als bei der unteren Grenze.

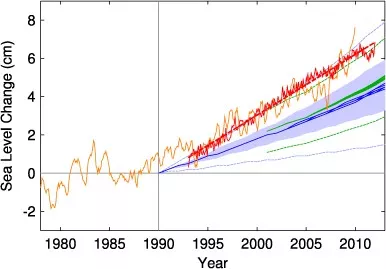

Es gab und gibt tatsächlich Modellergebnisse, in denen Klimaveränderungen überschätzt worden sind – allerdings auch eine ganze Reihe, die sich im Nachhinein als zu konservativ herausgestellt haben, die also von der Realität sogar noch überholt wurden. Beispielsweise wiesen Rahmstorf et al. 2012 darauf hin, dass die Meeresspiegel seit den 1990er Jahren stärker anstiegen als einst in IPCC-Sachstandsberichten auf der Basis von Modellrechnungen projiziert (Abbildung 6). Der durchschnittliche Anstieg zwischen 1993 und 2010 betrug demnach laut Satellitenmessungen 3,2 mm pro Jahr, während beispielsweise der Dritte Sachstandsbericht des IPCC aus dem Jahr 2001 lediglich einen jährlichen Anstieg von rund 2 mm erwartet hatte.

Abbildung 6: Veränderung des Meeresspiegels – Gezeitenpegelmessungen sind orange dargestellt, die erst seit Anfang der neunziger Jahre vorliegenden Satellitendaten rot. Die blaue Fläche zeigt die Projektionen des Dritten IPCC-Reports von 2001 (mit der blauen Linie als Mittelwert), die grünen Linien zeigen entsprechend Ober- und Untergrenze sowie Mittelwert aus dem Vierten IPCC-Sachstandsbericht. Die reale Entwicklung lag am oberen Rand bzw. über vorherigen Modellprojektionen; Quelle: Rahmstorf et al. 2012

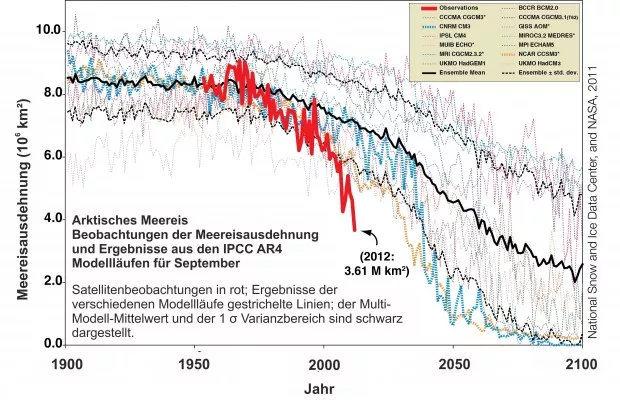

Auch die Schmelze des arktischen Meereises während der Sommermonate ist weitaus stärker und schneller ausgefallen, als einst in Klimamodellen vorhergesagt (Abbildung 7).

Abbildung 7: Veränderung der Ausdehnung des arktischen Meereises, jeweils für den Monat September eines Jahres, in Millionen Quadratkilometer– die fette rote Linie zeigt die reale Entwicklung seit Mitte des 20. Jahrhunderts, die feinen bunten Linien zeigen die Ergebnisse von 13 verschiedenen Modellen aus dem Vierten IPCC-Sachstandsbericht, die fett-schwarze Linie das Mittel daraus; Quelle: IPCC/NSDC/Nasa/AWI

Wieviel Genauigkeit kann man überhaupt erwarten?

Gelegentlich heißt es noch immer, die Menschheit solle mit Klimaschutzmaßnahmen warten, bis die Ergebnisse von Klimamodellen noch sicherer seien. Doch selbst mit perfekten Modellen würden wegen des prinzipiell chaotischen Charakters des Klimasystems Unsicherheiten bleiben. Alle Feinheiten des Klimas zu simulieren, ist nach menschlichem Ermessen unmöglich – schon heute aber sind die Modelle so weit, dass sie langfristige Klimatrends zuverlässig simulieren können.

Wer also auf absolute Sicherheit bei der Antwort auf alle klimawissenschaftlichen Fragen warten wollte, könnte niemals etwas unternehmen. Üblicherweise aber handeln Menschen bereits bei gewissen Wahrscheinlichkeiten: Wer etwa mit 90- oder 95-prozentiger Sicherheit weiß, dass sich an Gefahrenstellen bei überhöhter Geschwindigkeit ein Autounfall ereignet, der wird sich dort sicherlich an das Tempolimit halten. Im übrigen ist es in der Politik alles andere als ungewöhnlich, Entscheidungen auf der Basis einer unsicherer Faktenlage zu treffen: Bei Haushaltsverhandlungen zum Beispiel stützen sich Politiker auf Steuerschätzungen – und deren Verlässlichkeit liegt weit unter jener von modernen Klimamodellen.

John Cook/klimafakten.de, Juli 2010;

zuletzt aktualisiert: November 2022